Des Öfteren werde ich gefragt welche die Beste Möglichkeit ist die indexierung einer Seite durch Google zu unterbinden.

Methoden um die indexierung von webseiten zu unterbinden

Dazu gibt es bekannterweise verschiedene Möglichkeiten, am interessantesten ist hierbei der Einsatz der robots.txt sowie den meta noindex-Metatag .

Klingt erst mal einfach, ist es aber nicht! 😉

Der Irrglaube

Weit verbreitet ist der Irrglaube dass eine in der robots.txt mit disallow markierte URL nicht indexiert werden kann. Das ist schlichtweg falsch! Die robots.txt dient nur zur Steuerung des jeweiligen Crawlers der Suchmaschinenanbieter. In der Regel halten sich diese an die Einträge in der robots.txt, eine Pflicht dazu gibt es allerdings nicht. Praxis Erfahrungen zeigen das selbst Google sich nicht immer an diese Einträge hält.

Übrigens der historische Zweck der robots.txt war, den Crawler von den Bereichen der Website fern zu halten, die eine besonders hohe Serverlast erzeugten. Der Nebeneffekt dabei: die per robots.txt “geschützten” URLs konnten nicht in den Index gelangen.

Aktuell ist es allerdings so, das Google selbst eintscheidet welche Links sie verfolgen und indexieren und welche nicht. Hat ein Link bzw. eine Seite für Google eine sehr hohe Bedeutung, so kann bereits ein Link auf eine URL reichen um die URL in den Index mit aufzunehmen. Dabei nimmt Google so gar Seiten auf, wenn sie vom Crawler noch nicht einmal besucht wurden.

Und schwups sind Seiten im Index die per robots.txt gesperrt sind.

Die Praxis-Falle

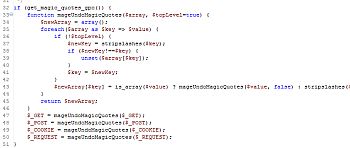

In der Praxis würde jetzt der Webseitenbetreiber nachträglich ein meta-tag mit noindex setzen – <meta name=“robots“ content=“noindex“>. Gut gemeint aber jetzt passiert folgendes: nix

???

Da die Seite per Disallow-Anweisung in der robots.txt-Datei für den crawler gesperrt ist, besucht dieser die Seite nicht und z.B. Google kennt diesen Meta-Tag auf dieser Seite nicht, da die Seite selbst nicht besucht wird.

Der Einsatz von robots.txt und des Noindex-Metatags widerspricht sich hiermit und deshalb sollten die Einträge abgestimmt werden!

robots.txt und metatag-nofollow richtig einsetzen

Wie lösen wir jetzt das Problem bzw. wie setzen wir die beiden „Tools“ korrekt ein?

Die robots.txt sollte immer nur dann verwendet werden, wenn es erwünscht ist dass ein Crawler auf eine geschützten URLs nicht zugreifen soll oder einfach die Last des Servers gesenkt werden soll. Das kann sein z.b. der Login-Bereich, bestimmte Bilder, Dateien, etc. pp, auch das duplicate Content Problem kann damit angegangen werden.

So erreichen wir dass der Crawler sich nicht mit unnötigen URLs verlustiert und anschließend keine Ressourcen mehr für die wichtigen Seiten übrig hat. Aus SEO-Sicht müssen wir ggf. damit leben, dass manche URLs trotzdem im Google-Index gelistet werden.

Wollen wir definitiv das Listing einer Seite im Google-Index verhindern, so kommen wir um den Einsatz eines noindex-Metatag nicht herum. Dabei ist zu berücksichtigen dass die Suchmaschinen Zugriff auf diese Seite haben und sie NICHT per robots.txt als disallow markiert ist.

Übrigens, der Einsatz des nofollow-attributes für links ist nur eine Empfehlung für die Suchmaschinen diese Seite nicht zu indexieren. In der Praxis hält sich Google sowieso nicht daran, bewertet die Links nur schlechter beim Ranking. Hinzu kommt das Google seiten auch negativ sieht welche nur nofollow-tags haben. Ist ja klar, die Seite erlaubt Google keine ausgehenden Links zu scannen und ist für den Crawler eine Sackgasse.

Wenn euch der Tipp geholfen hat, bitte diesen Artikel auch bei Google+ und Facebook teilen, danke für euren Support!